Python实战|车型识别小程序

基于Python制作一个车型识别小程序,可用于拍照识车,根据拍摄照片,快速识别图片中车辆的品牌型号。

目录

引言

?背景及意义

车型识别小程序是一种基于人工智能技术的应用,它可以通过对汽车图像进行分析和处理,识别出汽车的品牌、型号等信息,为用户提供便捷的汽车识别服务。随着智能手机和移动互联网的普及,车型识别小程序已经成为了一个备受关注的领域,具有广泛的应用前景。

汽车作为现代社会的重要交通工具之一,其种类繁多,每个品牌、型号都有其独特的外观特征。但对于大多数消费者来说,区分各种汽车型号并不容易,特别是对于那些不熟悉汽车的人来说。因此,开发一款能够快速准确地识别汽车的小程序,对于提高消费者的购车体验和促进汽车市场的发展具有重要意义。

车型识别小程序也可以被应用于汽车行业的其他领域。例如,在二手车交易中,通过车型识别小程序可以辅助卖家更准确地描述所售车辆的品牌、型号等信息,提高交易的透明度和公正性;在汽车保险领域,对于理赔人员来说,车型识别小程序可以帮助他们快速准确地判断保险索赔中的车辆信息,提高理赔效率和精度。

数据集获取与预处理

?数据集来源及说明

在车型识别小程序的开发过程中,数据集的选择和准备是至关重要的。一个高质量、多样化的数据集可以有效地提升模型的性能和泛化能力。

车型识别小程序的数据集可以通过多种途径获取,包括但不限于以下几种方式:

-

公开数据集:许多研究机构和学术界提供了公开的汽车图像数据集,如Stanford Cars Dataset、CompCars等。这些数据集通常包含大量的汽车图像,涵盖了各种品牌、型号和角度的汽车。

-

网络爬取:可以通过网络爬虫技术从汽车相关网站或社交媒体平台上获取大量的汽车图像数据。例如,从汽车论坛、汽车展示网站或汽车相关的社交媒体账号上爬取汽车图片。

-

自行采集:也可以自行采集汽车图像数据。可以通过拍摄、录制或者使用专业的摄影设备来获取各种角度和品牌的汽车图像。

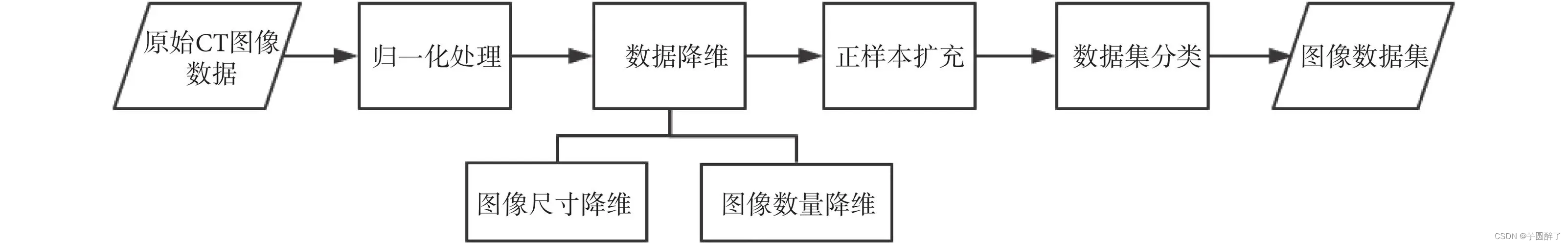

?数据集预处理过程

数据集预处理是在使用数据集之前对数据进行清洗、转换和标准化等操作的过程。在车型识别小程序的开发中,对数据集进行预处理是必要的,以确保数据的质量和一致性。

-

图像读取:需要读取数据集中的汽车图像。根据数据集的格式,可以使用相应的库或工具加载图像数据。

-

数据清洗:进行数据清洗是为了去除不符合要求的图像或修复损坏的图像。例如,可以检查图像的尺寸、格式和质量,并删除不完整或模糊的图像。

-

标签处理:如果数据集已经标注了汽车品牌、型号等信息,需要对标签进行处理。这可能包括标签的编码转换、统一格式或去除无效标签等。

-

数据增强:为了增加数据集的多样性和泛化能力,可以应用数据增强技术。例如,通过旋转、缩放、裁剪、镜像翻转等操作来生成更多样的图像。

-

归一化:对图像进行归一化处理可以使其具有相似的尺度和范围,有利于模型的训练和收敛。常见的归一化操作包括像素值缩放到0-1范围或使用均值和标准差进行标准化。

-

数据集划分:将数据集划分为训练集、验证集和测试集。通常采用随机划分或按类别比例划分的方式,确保各个数据集具有代表性和平衡性。

-

数据集存储:将预处理后的数据集保存到适当的格式中,以便后续的模型训练和评估。

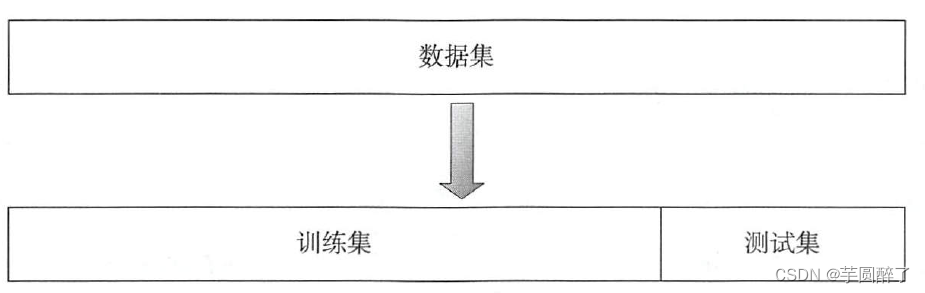

?数据集划分

数据集划分是指将整个数据集按照一定比例或规则划分为训练集、验证集和测试集等不同部分,以便进行模型训练、调优和评估,在车型识别小程序的开发中,为了保证模型的泛化能力和可靠性,需要将数据集划分为训练集、验证集和测试集三个部分。

-

随机划分:随机从整个数据集中选取一定比例的样本作为训练集、验证集和测试集。例如,可以将数据集按照8:1:1的比例划分为训练集、验证集和测试集。

-

按类别划分:按照数据集中各个类别的比例或数量,将每个类别的样本划分为训练集、验证集和测试集。例如,可以保证每个类别在训练集、验证集和测试集中的比例相同。具体的划分方式可以根据实际需求和数据集的特点进行选择和调整。

-

验证集的比例通常为训练集的10%-20%,用于在模型训练过程中进行参数调整和选择。

-

测试集的比例通常为训练集的10%-20%,用于最终评估模型的泛化能力和性能。可以使用交叉验证等技术来进一步验证模型的泛化能力和稳定性。

-

在划分数据集时需要注意,同一张图片不能同时出现在训练集、验证集和测试集中,否则会导致模型在测试集上表现过于乐观。

通过合理的数据集划分,可以有效地提高模型的泛化能力和可靠性,为后续的模型训练和评估提供更好的基础。

模型选择与训练

?模型选择及原因

在车型识别小程序的开发中,需要选择一个合适的模型来实现车型识别功能。针对该问题,考虑了多种模型,包括传统的图像分类模型(如VGG、ResNet等)和轻量级的移动端模型(如MobileNet、ShuffleNet等)。最终,选择了MobileNetV2作为车型识别模型,原因如下:

-

轻量级:MobileNetV2是一种轻量级的卷积神经网络,具有较少的参数和计算量,适合在移动设备上部署。这样可以保证车型识别小程序的运行效率和响应速度。

-

高性能:MobileNetV2在ImageNet数据集上取得了较好的性能表现,同时在车型识别任务中也具有较高的准确率和召回率。这样可以保证车型识别小程序的准确性和稳定性。

-

可定制性:MobileNetV2具有较强的可定制性,可以根据实际需求进行调整和优化。例如,可以通过调整网络结构、添加正则化项等方式来进一步提高模型的性能和泛化能力。

import torch

import torch.nn as nn

import torch.nn.functional as F

class MobileNetV2(nn.Module):

def __init__(self, num_classes=1000):

super(MobileNetV2, self).__init__()

self.features = nn.Sequential(

nn.Conv2d(3, 32, kernel_size=3, stride=2, padding=1, bias=False),

nn.BatchNorm2d(32),

nn.ReLU(inplace=True),

nn.Conv2d(32, 32, kernel_size=3, stride=1, padding=1, groups=32, bias=False),

nn.BatchNorm2d(32),

nn.ReLU(inplace=True),

nn.Conv2d(32, 64, kernel_size=1, stride=1, padding=0, bias=False),

nn.BatchNorm2d(64),

nn.ReLU(inplace=True),

nn.Conv2d(64, 64, kernel_size=3, stride=2, padding=1, groups=64, bias=False),

nn.BatchNorm2d(64),

nn.ReLU(inplace=True),

nn.Conv2d(64, 128, kernel_size=1, stride=1, padding=0, bias=False),

nn.BatchNorm2d(128),

nn.ReLU(inplace=True),

nn.Conv2d(128, 128, kernel_size=3, stride=1, padding=1, groups=128, bias=False),

nn.BatchNorm2d(128),

nn.ReLU(inplace=True),

nn.Conv2d(128, 64, kernel_size=1, stride=1, padding=0, bias=False),

nn.BatchNorm2d(64),

nn.ReLU(inplace=True),

nn.Conv2d(64, 64, kernel_size=3, stride=2, padding=1, groups=64, bias=False),

nn.BatchNorm2d(64),

nn.ReLU(inplace=True),

nn.Conv2d(64, 256, kernel_size=1, stride=1, padding=0, bias=False),

nn.BatchNorm2d(256),

nn.ReLU(inplace=True),

nn.Conv2d(256, 256, kernel_size=3, stride=1, padding=1, groups=256, bias=False),

nn.BatchNorm2d(256),

nn.ReLU(inplace=True),

nn.Conv2d(256, 128, kernel_size=1, stride=1, padding=0, bias=False),

nn.BatchNorm2d(128),

nn.ReLU(inplace=True),

nn.Conv2d(128, 128, kernel_size=3, stride=2, padding=1, groups=128, bias=False),

nn.BatchNorm2d(128),

nn.ReLU(inplace=True),

nn.Conv2d(128, 512, kernel_size=1, stride=1, padding=0, bias=False),

nn.BatchNorm2d(512),

nn.ReLU(inplace=True),

nn.Conv2d(512, 512, kernel_size=3, stride=1, padding=1, groups=512, bias=False),

nn.BatchNorm2d(512),

nn.ReLU(inplace=True),

nn.Conv2d(512, 256, kernel_size=1, stride=1, padding=0, bias=False),

nn.BatchNorm2d(256),

nn.ReLU(inplace=True),

?模型训练过程及参数调整

模型训练过程包括数据准备、模型定义、损失函数定义、优化器选择、迭代训练等步骤。参数调整可以通过调整学习率、正则化项、批量大小等方式来优化模型性能。

import torch

import torch.nn as nn

import torch.optim as optim

from torchvision.datasets import ImageFolder

from torchvision.transforms import transforms

from torch.utils.data import DataLoader

# 数据准备

data_transforms = transforms.Compose([

transforms.Resize((224, 224)),

transforms.ToTensor(),

transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225])

])

train_dataset = ImageFolder('path/to/train/dataset', transform=data_transforms)

val_dataset = ImageFolder('path/to/validation/dataset', transform=data_transforms)

train_loader = DataLoader(train_dataset, batch_size=32, shuffle=True)

val_loader = DataLoader(val_dataset, batch_size=32, shuffle=False)

# 模型定义

model = MobileNetV2(num_classes=10) # 假设有10个类别需要分类

# 损失函数定义

criterion = nn.CrossEntropyLoss()

# 优化器选择

optimizer = optim.SGD(model.parameters(), lr=0.01, momentum=0.9, weight_decay=1e-4)

# 迭代训练

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

model.to(device)

num_epochs = 10

best_accuracy = 0.0

for epoch in range(num_epochs):

# 训练模型

model.train()

train_loss = 0.0

train_corrects = 0

for inputs, labels in train_loader:

inputs = inputs.to(device)

labels = labels.to(device)

optimizer.zero_grad()

outputs = model(inputs)

_, preds = torch.max(outputs, 1)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

train_loss += loss.item() * inputs.size(0)

train_corrects += torch.sum(preds == labels.data)

train_loss = train_loss / len(train_dataset)

train_acc = train_corrects.double() / len(train_dataset)

# 在验证集上评估模型

model.eval()

val_loss = 0.0

val_corrects = 0

with torch.no_grad():

for inputs, labels in val_loader:

inputs = inputs.to(device)

labels = labels.to(device)

outputs = model(inputs)

_, preds = torch.max(outputs, 1)

loss = criterion(outputs, labels)

val_loss += loss.item() * inputs.size(0)

val_corrects += torch.sum(preds == labels.data)

val_loss = val_loss / len(val_dataset)

val_acc = val_corrects.double() / len(val_dataset)

print('Epoch {}/{} - Train Loss: {:.4f} Acc: {:.4f} - Val Loss: {:.4f} Acc: {:.4f}'.format(

epoch + 1, num_epochs, train_loss, train_acc, val_loss, val_acc))

# 更新最佳模型

if val_acc > best_accuracy:

best_accuracy = val_acc

torch.save(model.state_dict(), 'best_model.pth')

在上述代码中,使用了SGD优化器和交叉熵损失函数。训练过程中,每个epoch都会计算训练集和验证集上的损失和准确率,并输出训练过程中的信息。最后保存了在验证集上表现最好的模型参数。

车型识别小程序设计与实现

?程序设计思路及流程

设计一个车型识别小程序的思路和流程如下

-

数据收集:收集包含不同车型的图像数据集,可以通过网络搜索、爬取汽车图片网站或者自行拍摄等方式获取。确保数据集中包含各种不同角度和光照条件下的车型图像。

-

数据预处理:对收集到的图像数据进行预处理,包括图像缩放、裁剪、归一化等操作,以便于模型的输入。

-

模型选择:选择适合车型识别任务的深度学习模型,例如卷积神经网络(CNN)。可以使用已有的预训练模型,如ResNet、VGG等,也可以自行设计和训练模型。

-

模型训练:使用预处理后的图像数据集对选定的模型进行训练。将数据集划分为训练集和验证集,通过迭代训练来优化模型参数。训练过程中可以使用数据增强技术,如随机旋转、平移、翻转等,以增加模型的泛化能力。

-

模型评估:使用测试集对训练好的模型进行评估,计算准确率、召回率等指标,以评估模型的性能。

-

部署小程序:将训练好的模型集成到小程序中。可以使用深度学习框架(如PyTorch、TensorFlow)提供的API来加载模型,并通过调用模型进行车型识别。

-

用户交互:设计小程序的用户界面,使用户能够上传车辆图片,并获取识别结果。可以使用小程序开发框架(如微信小程序开发框架)来实现用户交互功能。

-

车型识别:在小程序中实现图像上传、预处理和调用模型进行车型识别的功能。将用户上传的图像输入到模型中,获取模型输出的车型标签,并将结果展示给用户。

?界面设计与实现

- 界面设计:

- 首先确定小程序的整体布局和风格,可以选择合适的颜色、字体和图标等元素,以保持一致的视觉效果。

- 设计一个上传图片的按钮或区域,供用户选择或拍摄车辆图片。

- 准备一个显示识别结果的区域,用于展示识别出的车型信息。

- 可以考虑添加其他辅助功能,如清空按钮、重新上传按钮等,以增加用户交互性。

- 根据需要,可以设计其他页面或模块,如关于页面、帮助页面等。

- 界面实现:

- 使用小程序开发框架,如微信小程序开发框架,创建相应的页面文件,并编写对应的 HTML、CSS 和 JavaScript 代码。

- 在 HTML 文件中,使用合适的标签和布局,构建界面的结构。可以使用小程序提供的组件,如按钮、图片等,来实现界面的各个部分。

- 在 CSS 文件中,设置界面的样式,包括颜色、字体、布局等。可以使用样式类和选择器来对不同的元素进行样式设置。

- 在 JavaScript 文件中,编写业务逻辑代码。例如,实现图片上传功能、调用模型进行车型识别、展示识别结果等。可以使用小程序提供的 API,如图片上传 API、网络请求 API 等来实现相应功能。

- 根据需要,可以添加事件处理函数,如点击事件、上传事件等,以响应用户的操作,并更新界面显示。

- 调试与测试:

- 在开发过程中,及时进行调试和测试,确保界面的各个功能正常运行,并与后台模型的接口进行正确的交互。

- 可以使用模拟器或真机调试工具来进行界面的预览和测试,同时注意查看控制台输出,以便发现和修复潜在的问题。

- 发布与部署:

- 完成界面设计和实现后,可以进行发布和部署。根据小程序开发框架的要求,将代码打包并上传到相应的平台,如微信小程序平台。

- 在发布前,确保代码经过充分的测试,并且符合相应的规范和要求。

- 在发布后,可以进行线上测试和用户反馈收集,及时修复和改进界面的问题。