c++部署yolov5模型

C++部署yolov5模型

前言

不可否认,yolov5在目标检测方面大杀四方,在 SOTA 榜上留下过万众瞩目的成绩,但是官网代码给的只有 python 版本的 infer 代码,要求不高的话,勉勉强强可以实现部署,现在,我想在 win 下实现 c++ 部署过程,主要原因有:

- c++编译的文件,直接

cp所有的dll以及exe到目标机器上就行,而python需要安装各种环境; - c++的效率高于

python; -

win下我感觉c++的部署与移植的便利性远远高于python;

谈到深度学习模型的部署问题,就引出来了几个常见的部署工具,例如 OpenVINO, tensorrt, onnxruntime等,以及基于这些框架又封装一层的,如 FastDeploy, mmdeploy等,这些工具各有特点,但对于目前的我来讲,就是想以最快的速度完成 ultracity/yolov5 生成的 pt 模型的部署,所以,选择了比较简单的 FastDeploy添加链接描述

现在这个 toolbox 能实现很多的功能,支持的模型也很多,有需要的话,可以自己上官网看看,这里就不做过多介绍了。

一、准备模型

FastDeploy 在调用 yolov5 的模型时,不是直接调用的 *.pt 文件,而是调用的 *.onnx(一种通用的深度学习模型)文件,因此,首先是需要对 *.pt 的文件进行格式转换,但并不是所有yolov5 的代码都支持 export *.pt to *.onnx 的功能,在这里,需要关注下 yolov5 的 tag ,大于等于 v6.0 的才有 export.py 这个文件,所以,如果是老用户,就不不需读此文章了。

python export --weights *.pt --include onnx

二、Fastdeploy准备

这个还是需要自己编译下的,我是用 cmake 编译的,具体步骤:

- 设置下

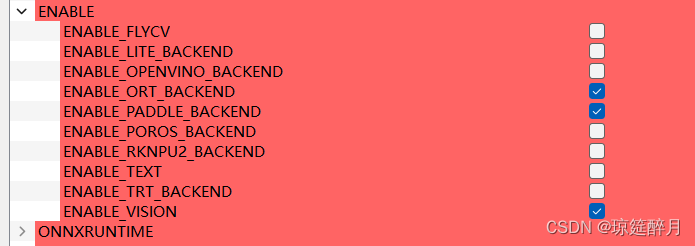

ENABLE目录下的选项: 我是用视觉模块,所以,我把

我是用视觉模块,所以,我把 ENABLE_VISION设置为ON, 并且,因为我需要调用onnx,也把ORT_BACKEND和PADDLE_BACKEND设置为ON,个人建议,用啥选啥,不用的先不要选,曾经遇到过坑,在编译的时候ENABLE_OPENVINO_BACKEND=ON,然后再程序运行的时候就卡住不动了,结果发现是因为缺少了一个*.xml的文件,如果没人指点的话,估计这一个月都不知道问题出在哪里。2. 设置with,

个人建议WITH_GPU,因为在运行的时候,有GPU就调用GPU了,没有GPU就调用CPU了,兼容性好点。

三 调用

如果第一,二步没啥问题,就恭喜了,后面的调用就更简单了,直接看下代码吧:

bool demo_yolov5onnx(const std::string& model_file, const std::string& img_path, const int& loop, const int& use_gpu) {

fastdeploy::RuntimeOption option; // Configuration information for model inference

if (use_gpu == 1) {

option.UseGpu();

} else {

option.UseCpu();

}

auto model = fastdeploy::vision::detection::YOLOv5(model_file, "hello", option);

if (!model.Initialized()) {

std::cerr << "Failed to initialize." << std::endl;

return false;

}

std::cout << "init successful" << std::endl;

cv::Mat im = cv::imread(img_path);

fastdeploy::vision::DetectionResult result;

clock_t t1, t2;

for (int i = 0; i < loop; i++) {

t1 = clock();

if (!model.Predict(im, &result)) {

std::cerr << "Failed to predict." << std::endl;

return false;

}

t2 = clock();

std::cout << "predict image cost time: " << t2 - t1 << std::endl;

}

std::cout << "=================================" << std::endl;

std::cout << result.Str() << std::endl;

std::cout << "=================================" << std::endl;

cv::Mat vis_im = fastdeploy::vision::VisDetection(im, result, 0.5);

cv::imwrite("vis_result.jpg", vis_im); // The visualization results are saved locally

return true;

}

调用还是比较简单的,也就三五句有用的语句。

总结

FastDeploy封装的还是挺简单的,使用很方便,但是,毕竟是二次开发的工具,在功能上,还是会受限的,所以,要想能更精通的实现模型部署的工作,还是需要学习下底层的部署工具(OpenVINO,ONNXRuntime, TensorRT)的使用以及对模型框架本身的理解。